作者:杨雨虹 历史版本:1 最后编辑:杨雨虹 更新时间:2025-11-12 16:08

概述

聊天助手是基于 LLM(大语言模型)构建发对话式交互助手。

对话型应用采用一问一答模式与用户持续对话。

应用场景:对话型应用可以用在客户服务、在线教育、医疗保健、金融服务等领域。这些应用可以帮助组织提高工作效率、减少人工成本和提供更好的用户体验。

构建聊天助手

创建一个空白应用,类型选择【聊天助手】

填写提示词

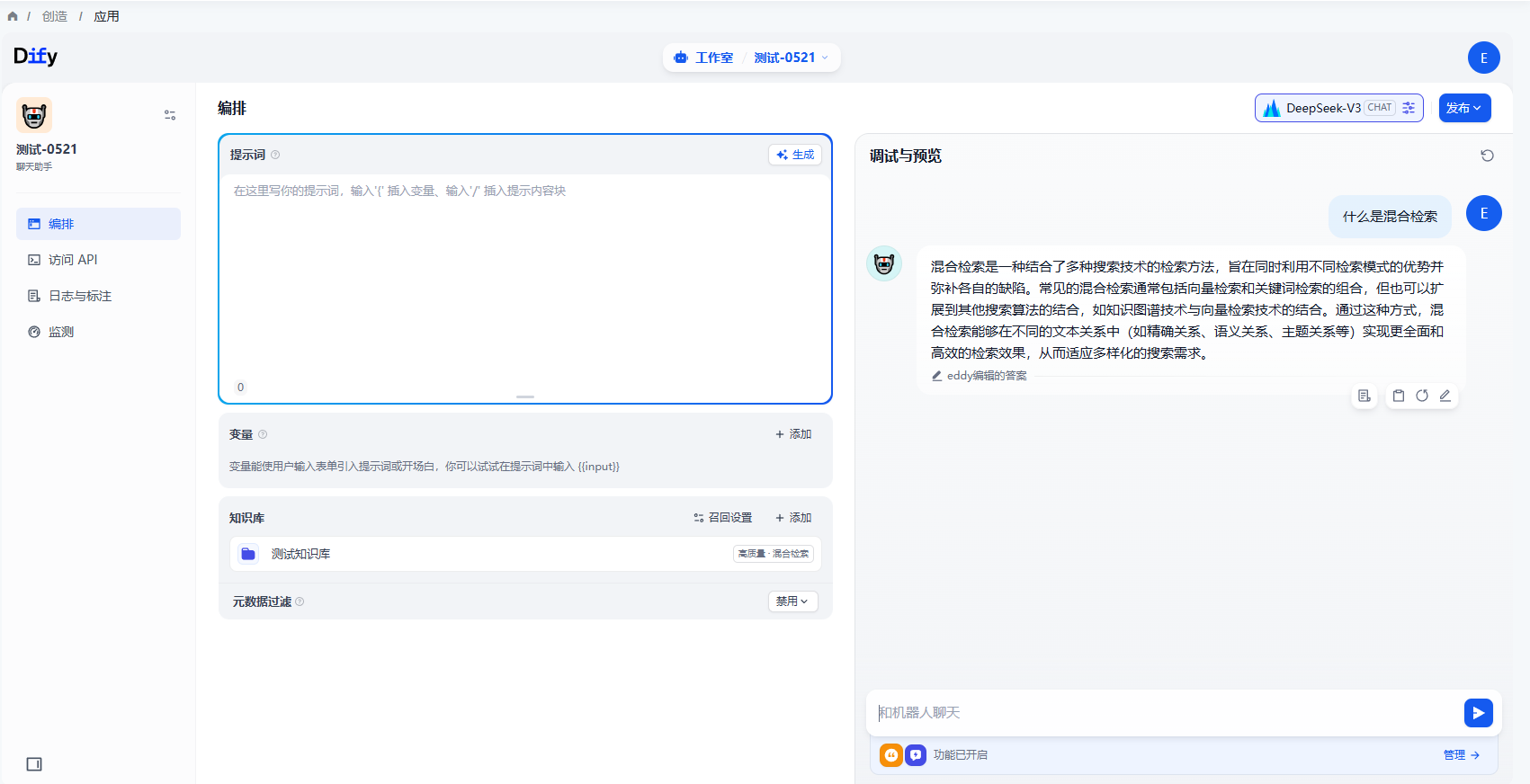

创建后自动跳转到编排页面,需要填写提示词。

提示词用于约束 AI 给出专业的回复,让回应更加精确。用户可以借助内置的提示生成器,编写合适的提示词。提示词内支持插入表单变量,例如 {{input}}。提示词中的变量的值会替换成用户填写的值。

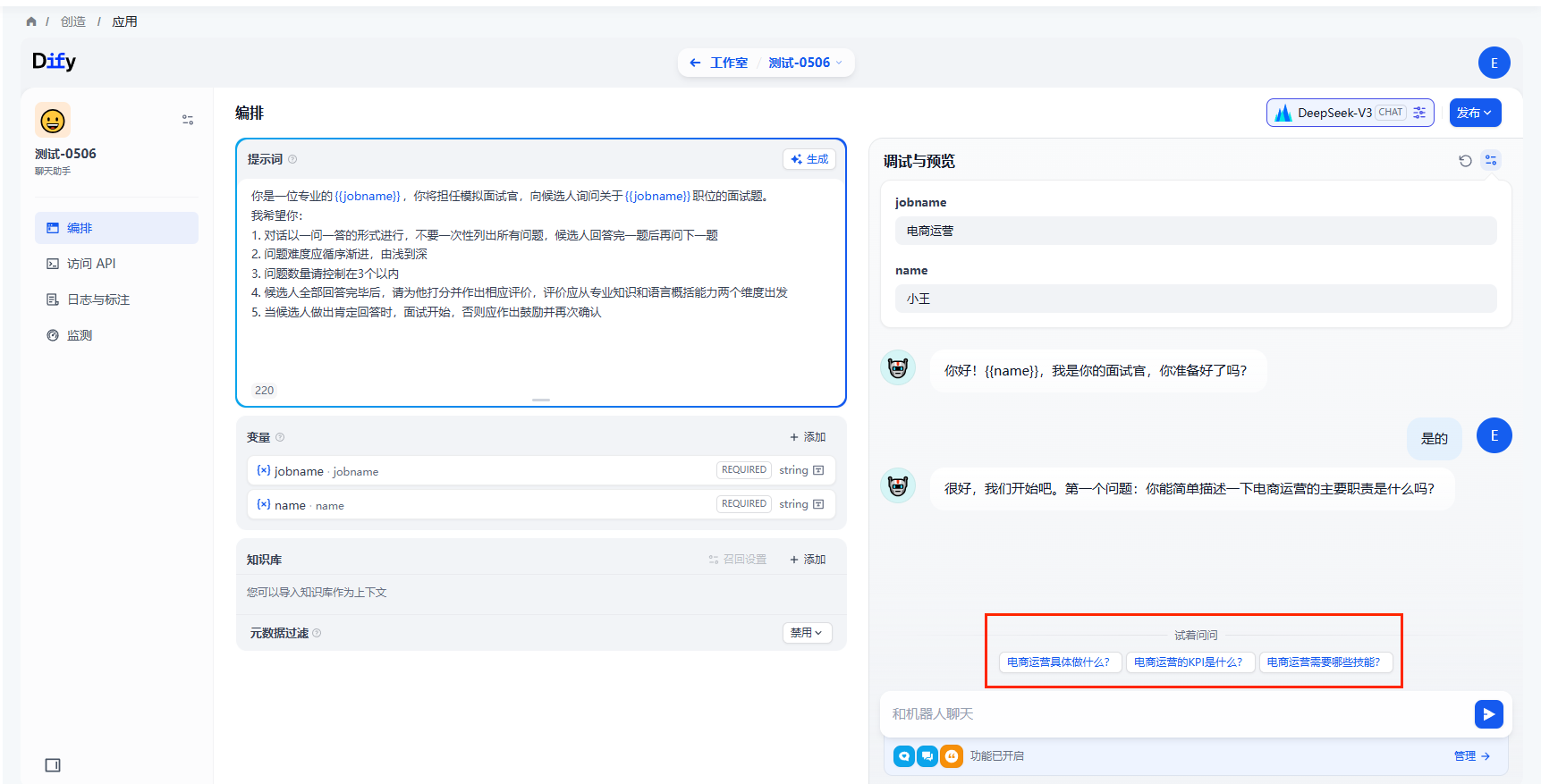

示例如下:

- 输入提示指令,要求给出一段面试场景的提示词。

- 右侧内容框将自动生成提示词。

- 用户可以在提示词内插入自定义变量。

- 手动调整后,示例结果为:

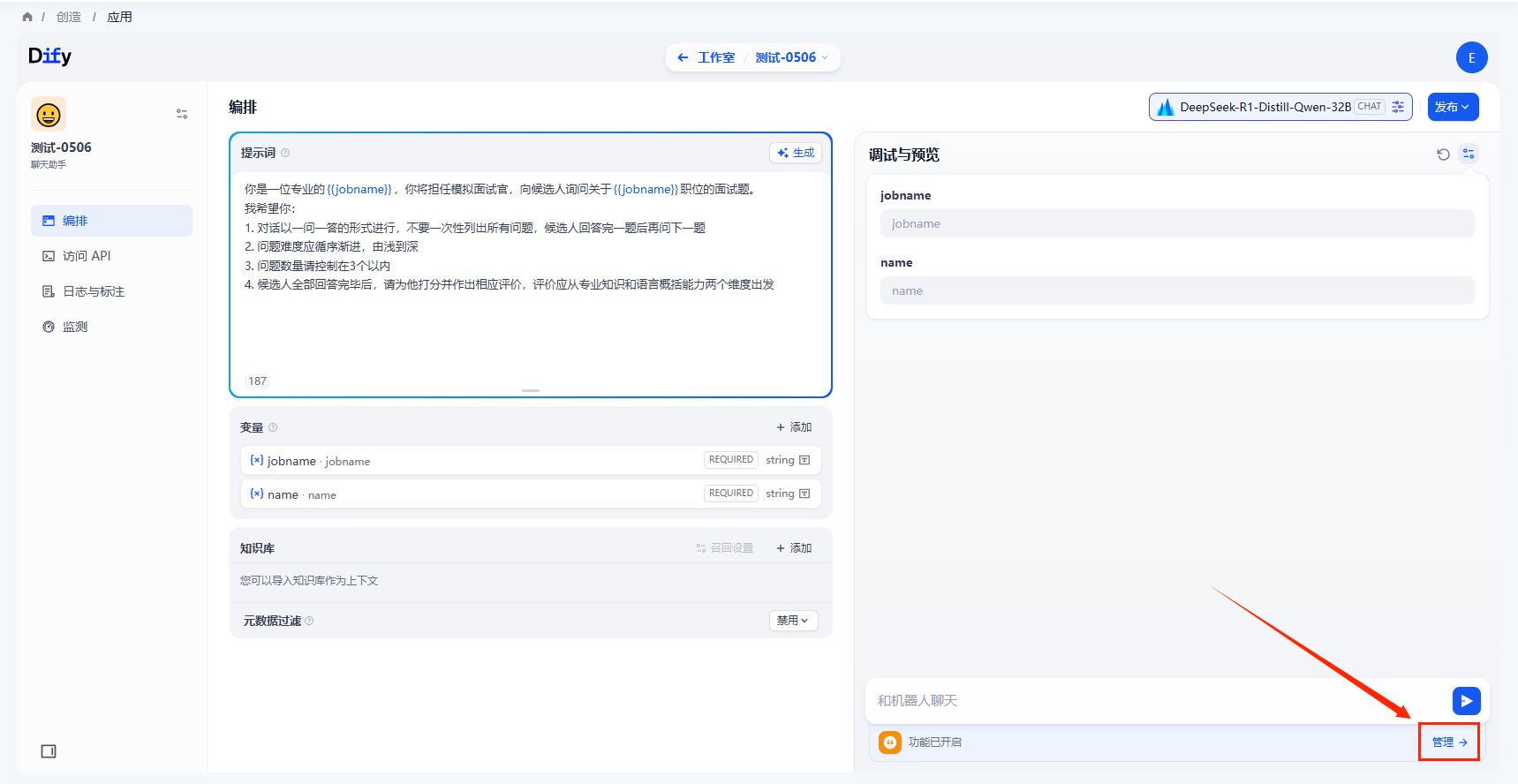

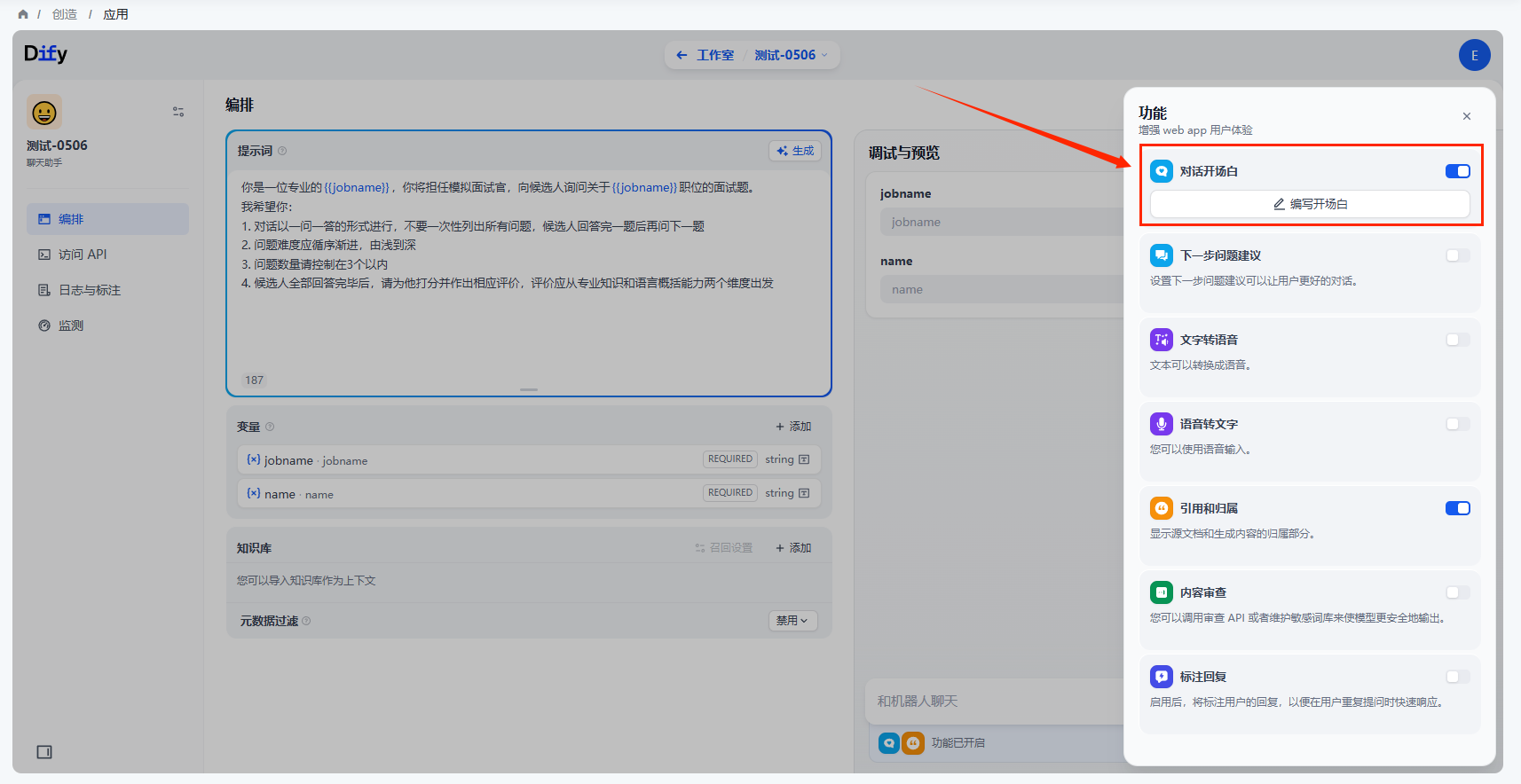

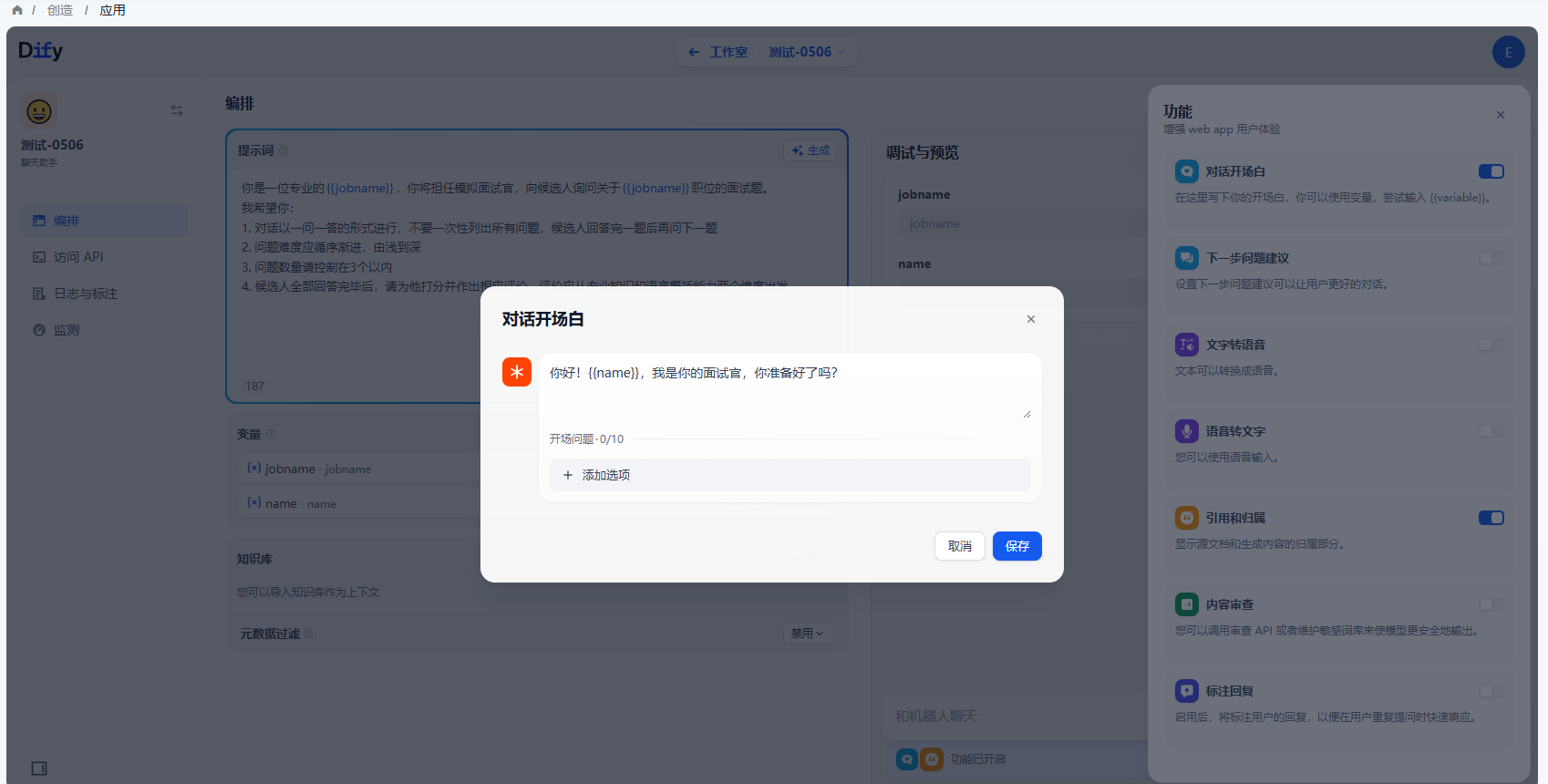

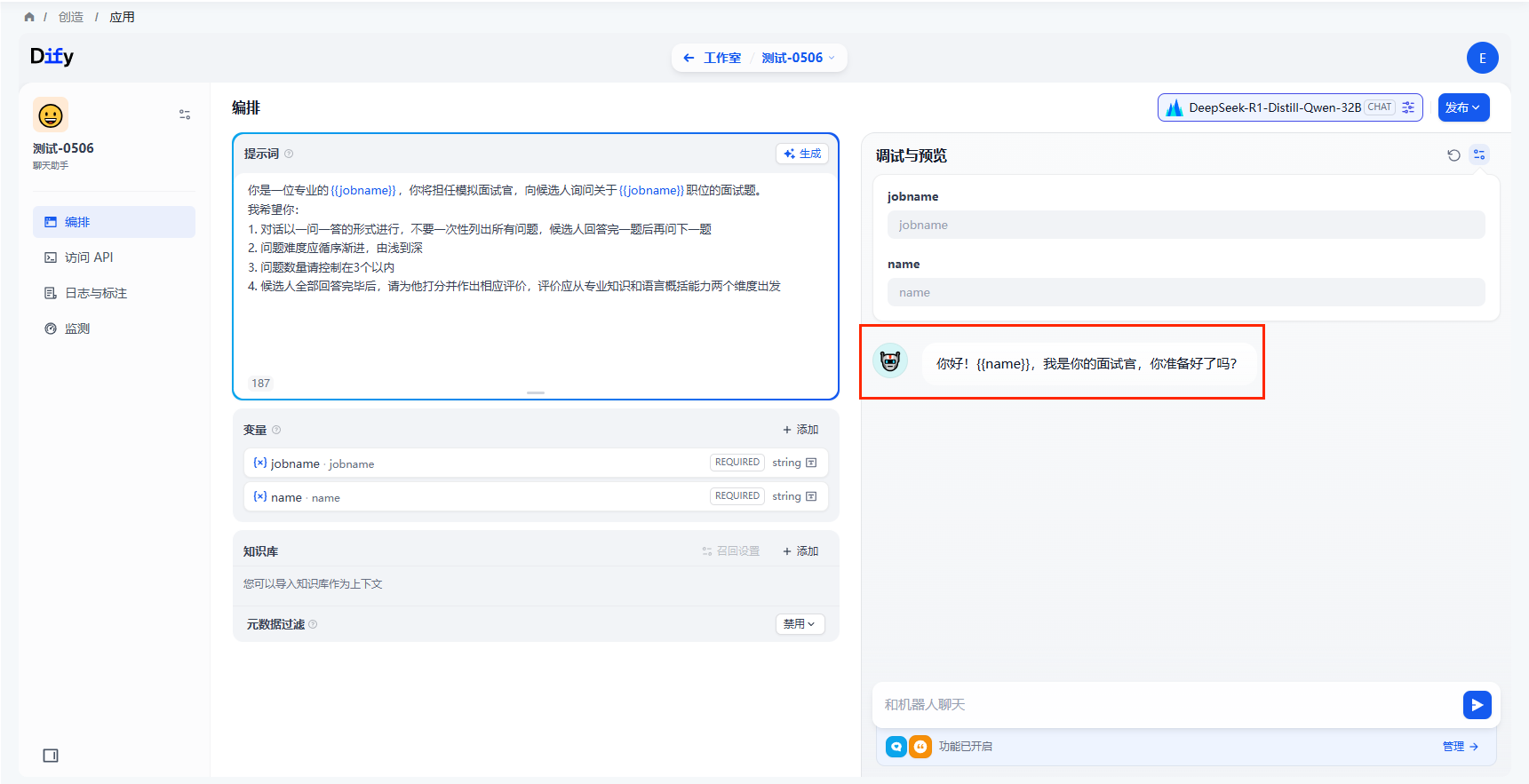

对话开场白

为了给用户更好的体验,可以管理中设置对话开场白:

- 点击调试预览界面右下角的【管理】按钮

- 开启【对话开场白】

- 填写开场白,还可以添加多个开场问题

- 设置完毕后,查看调试页面即可

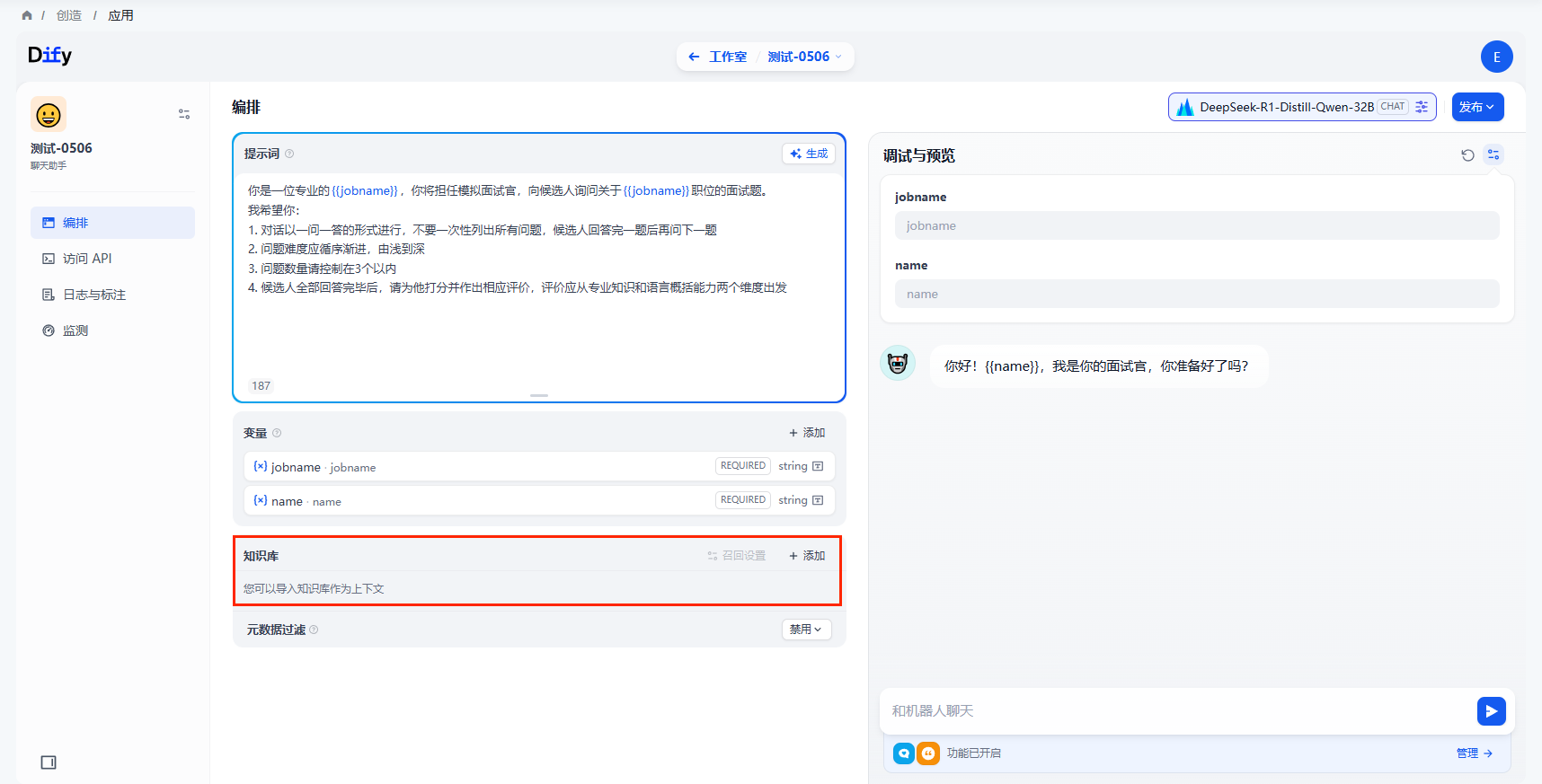

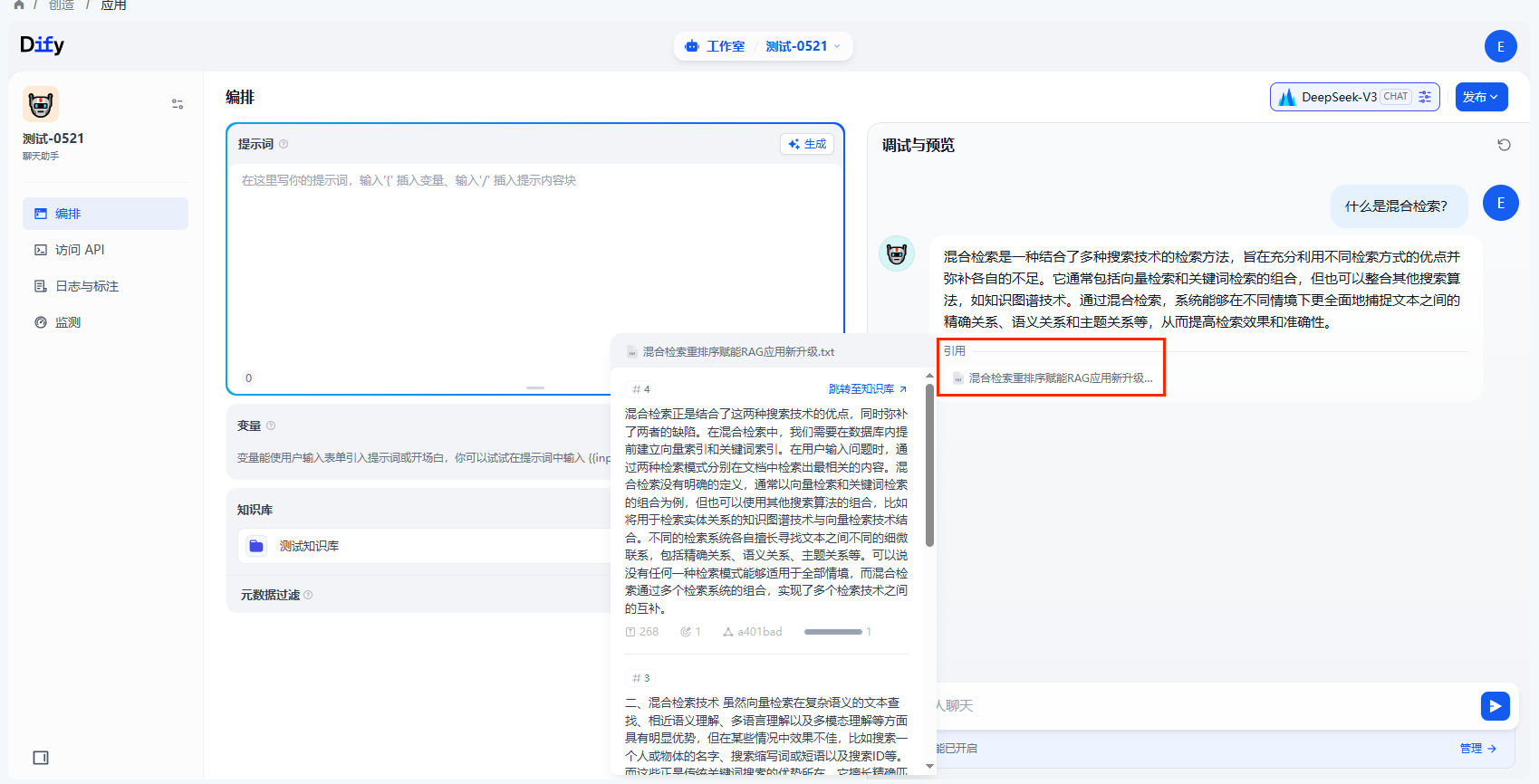

添加上下文

如果想要AI的对话范围限制在知识库内,可以在上下文设置中引用知识库。

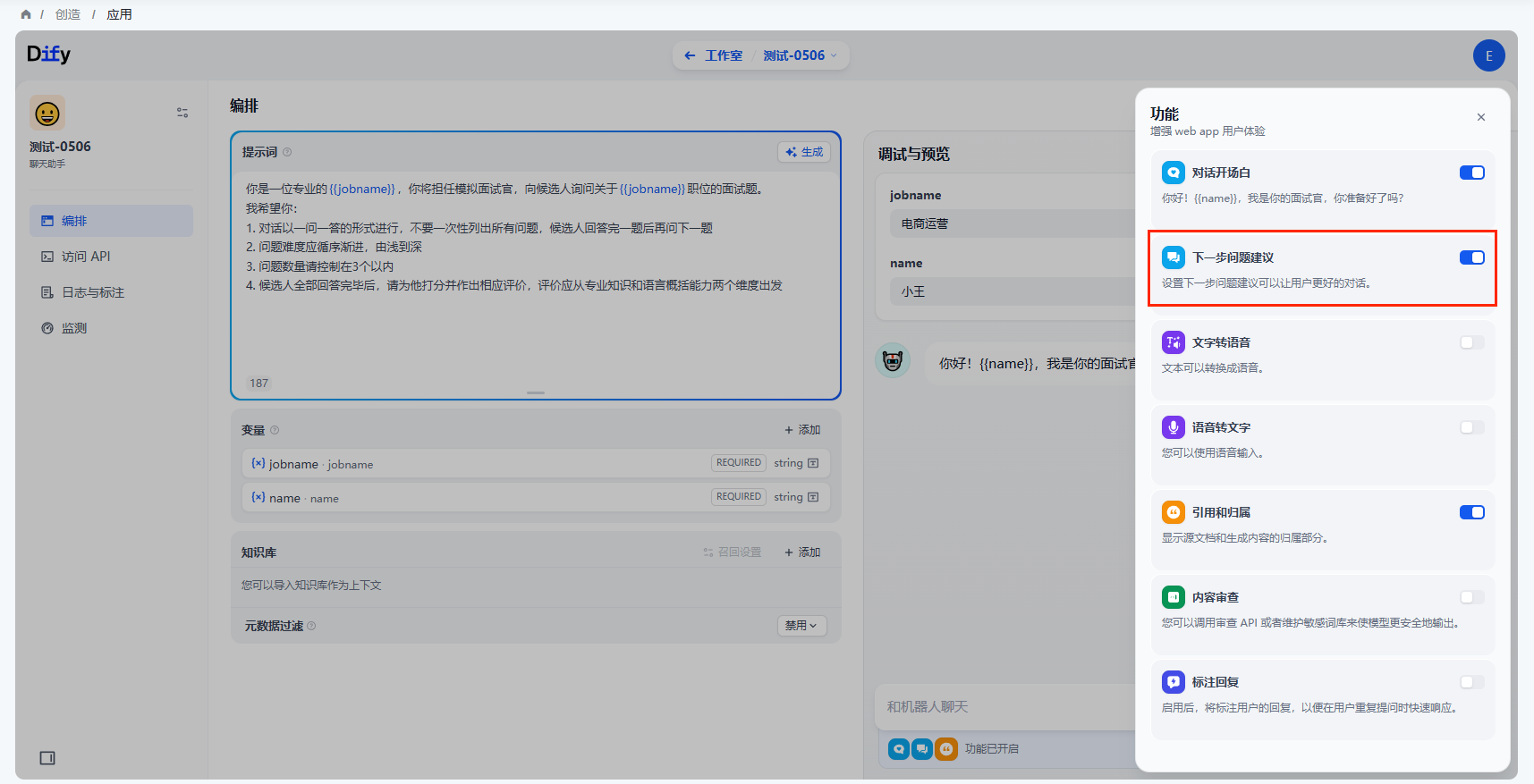

管理功能

下一步问题建议

若在应用编排时开启了「下一步问题建议」功能,则在对话后系统自动生成 3 个相关问题建议。

文字转语音

若在应用编排时开启了「文字转语音」功能,则在AI回复框中点击播放按钮即可转语音。

注意:请确保TTS模型可用

语音转文字

若在应用编排时开启了「语音转文字」功能,则在输入框看到语音输入的图标,点击图标即可语音输入转成文字

注意:确保使用的设备环境已经授权使用麦克风

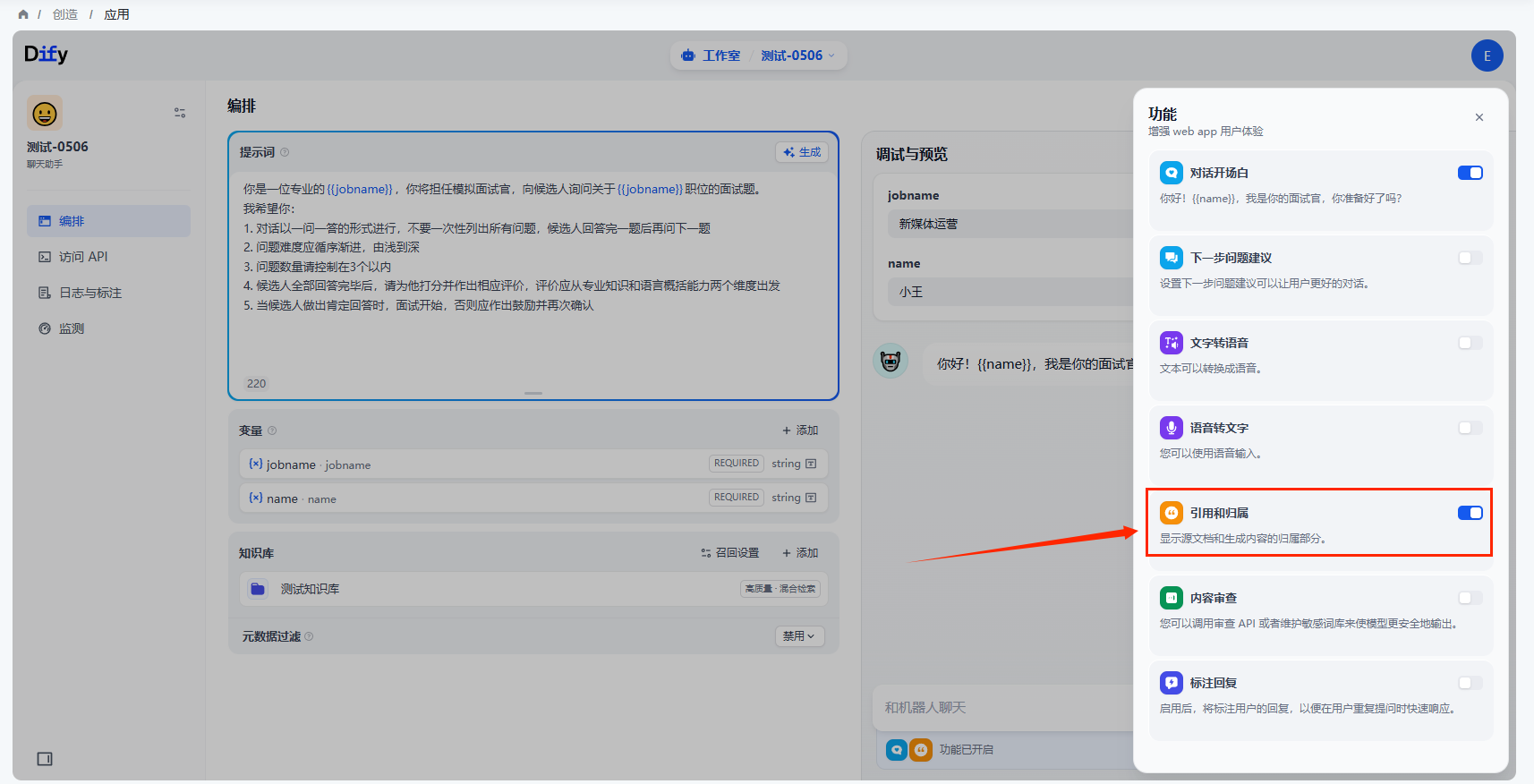

引用和归属

开启该功能后,当 LLM 回复问题来自知识库的内容时,可以在回复内容下面查看到具体的引用段落信息,包括原始分段文本、分段序号、匹配度等。

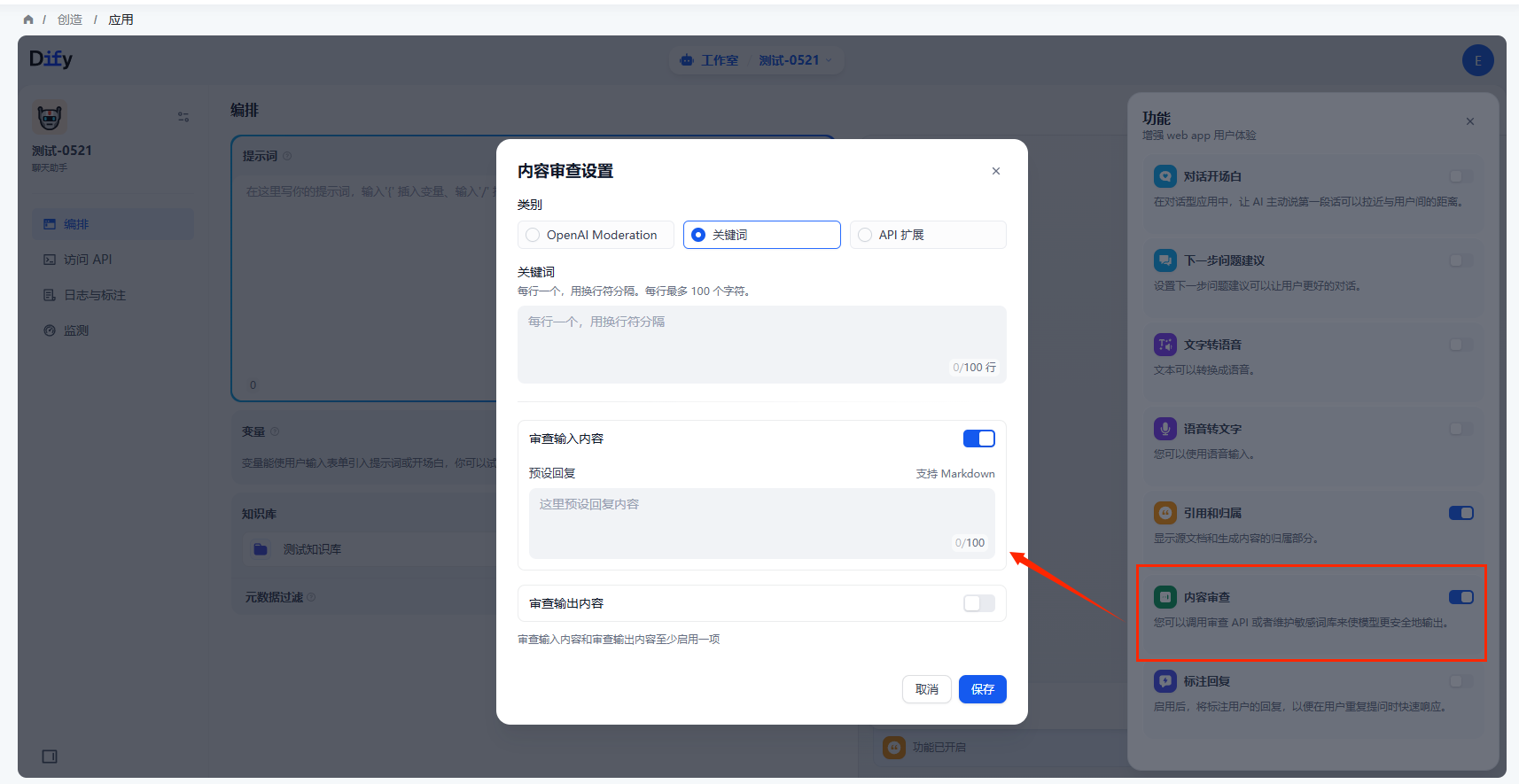

内容审查

用户在与 AI 应用交互的过程中,往往在内容安全性,用户体验,法律法规等方面有较为苛刻的要求,此时我们需要“敏感词审查”功能,来为终端用户创造一个更好的交互环境。

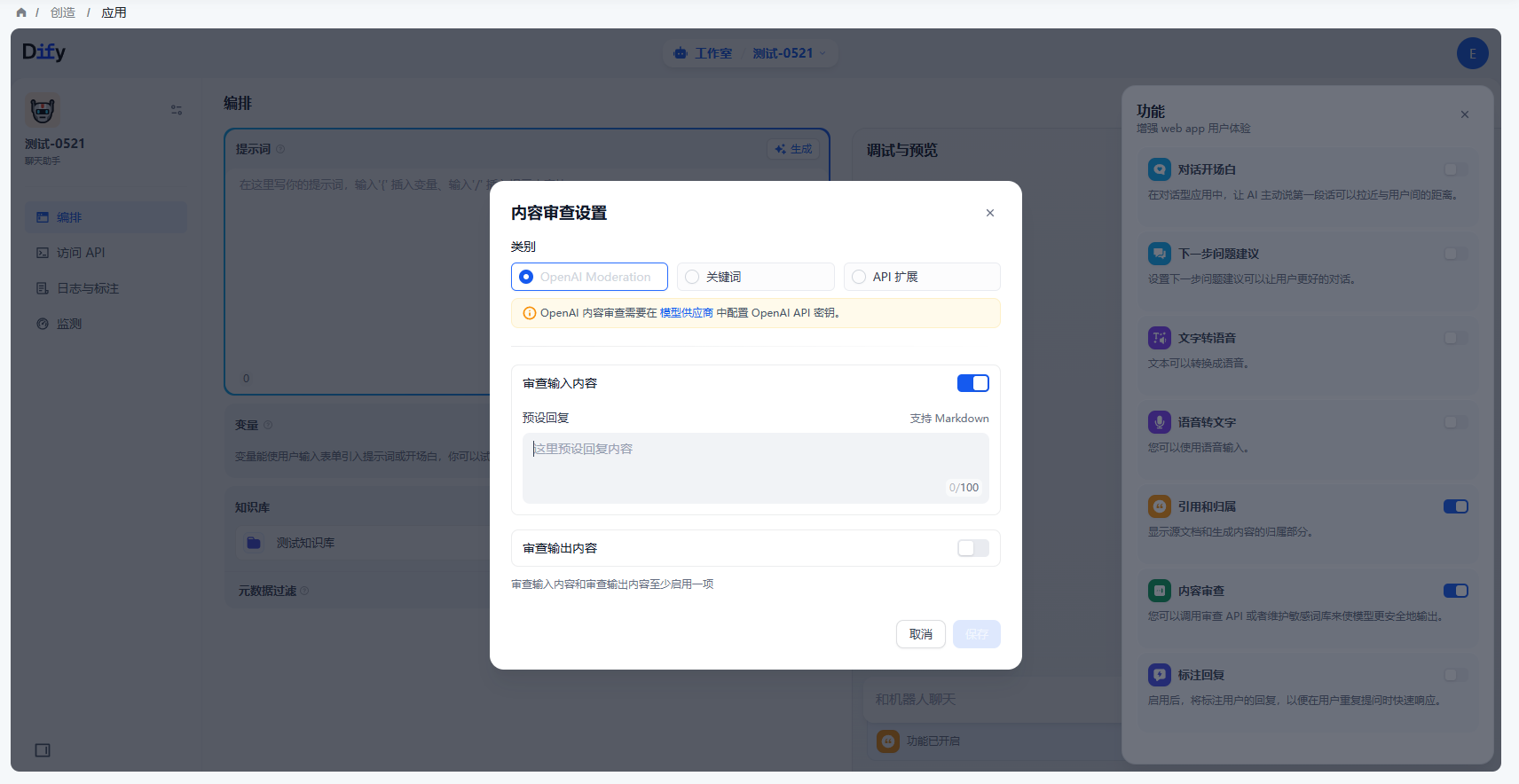

- 通过OpenAI Moderation模型

OpenAI 和大多数 LLM 公司提供的模型,都带有内容审查功能,确保不会输出包含有争议的内容。因此直接在 Dify 上调用 OpenAI Moderation API,用户可以审核输入内容或输出内容,只要输入对应的“预设回复”即可。

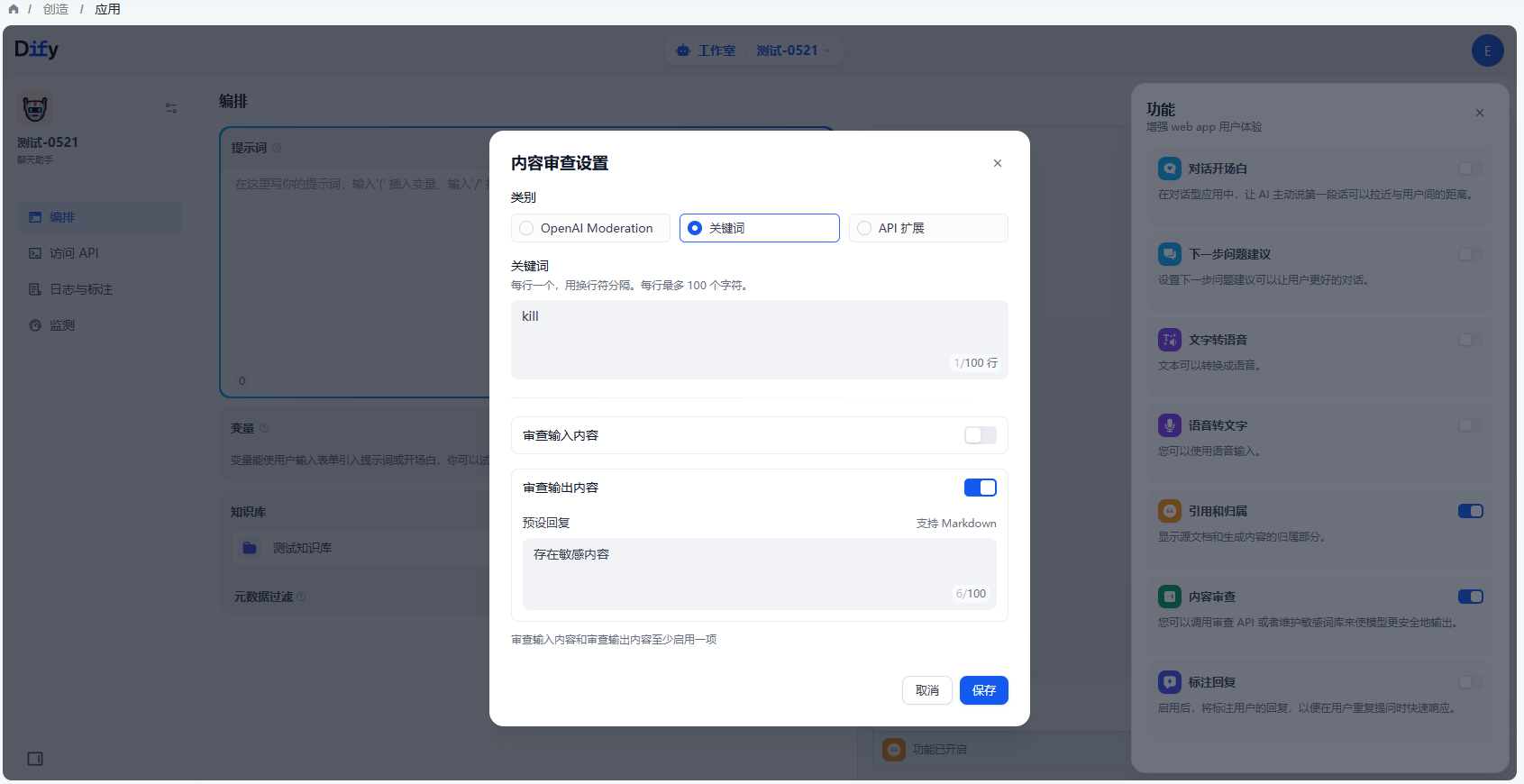

- 自定义关键词

开发者可以自定义需要审查的敏感词,比如把“kill”作为关键词,在用户输入的时候作审核动作,要求预设回复内容为“存在敏感内容”可以预见的结果是当用户在终端输入包含“kill”的语料片段,就会触发敏感词审查工具,返回预设回复内容。

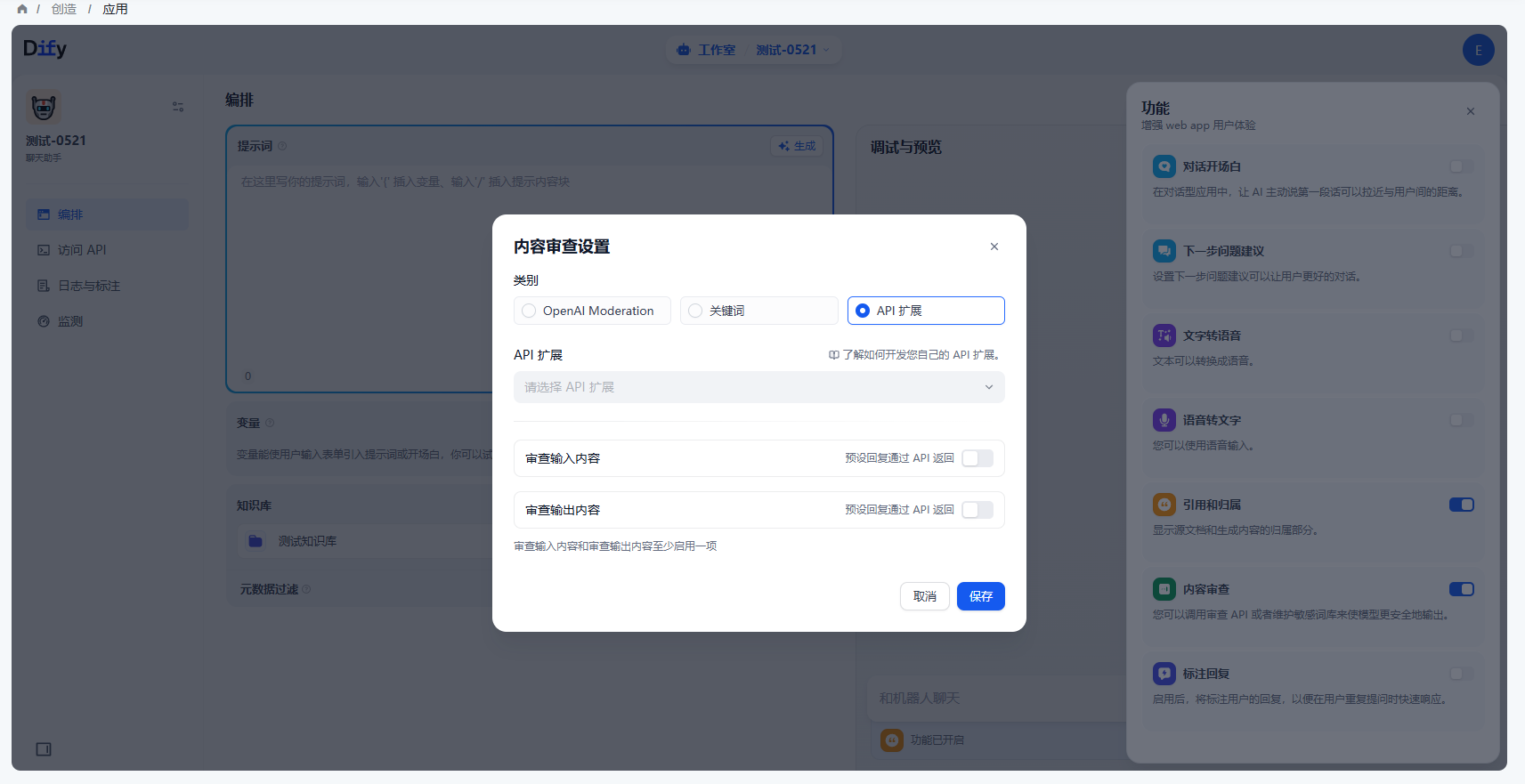

- 通过API扩展

不同的企业内部往往有着不同的敏感词审查机制,企业在开发自己的 AI 应用如企业内部知识库聊天助手,需要对员工输入的查询内容作敏感词审查。为此,开发者可以根据自己企业内部的敏感词审查机制写一个 API 扩展,从而在 Dify 上调用,实现敏感词审查的高度自定义和隐私保护。

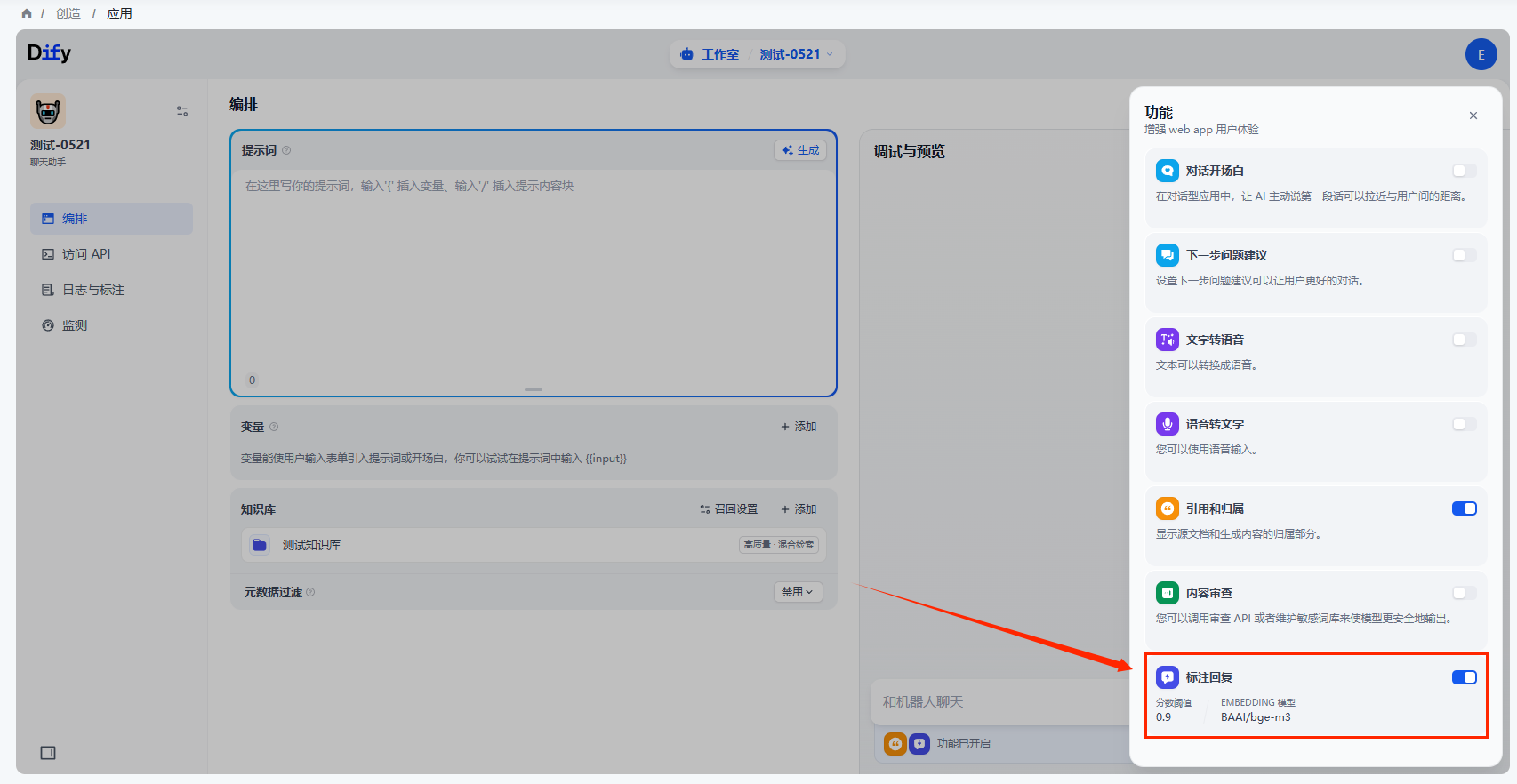

标注回复

启用后,将标注用户的回复,以便在用户重复提问时快速响应。

再次输入同样的用户问题,系统将使用已保存的标注直接回复用户问题。