概述

导入已有文本时,需要对文本内容进行分段和清洗,该步骤的作用是将长文本划分成多个内容分段,使得LLM在收到用户问题时,无需重复分析整个文档,而是可以定位至关键章节内容块,快速得到答案。

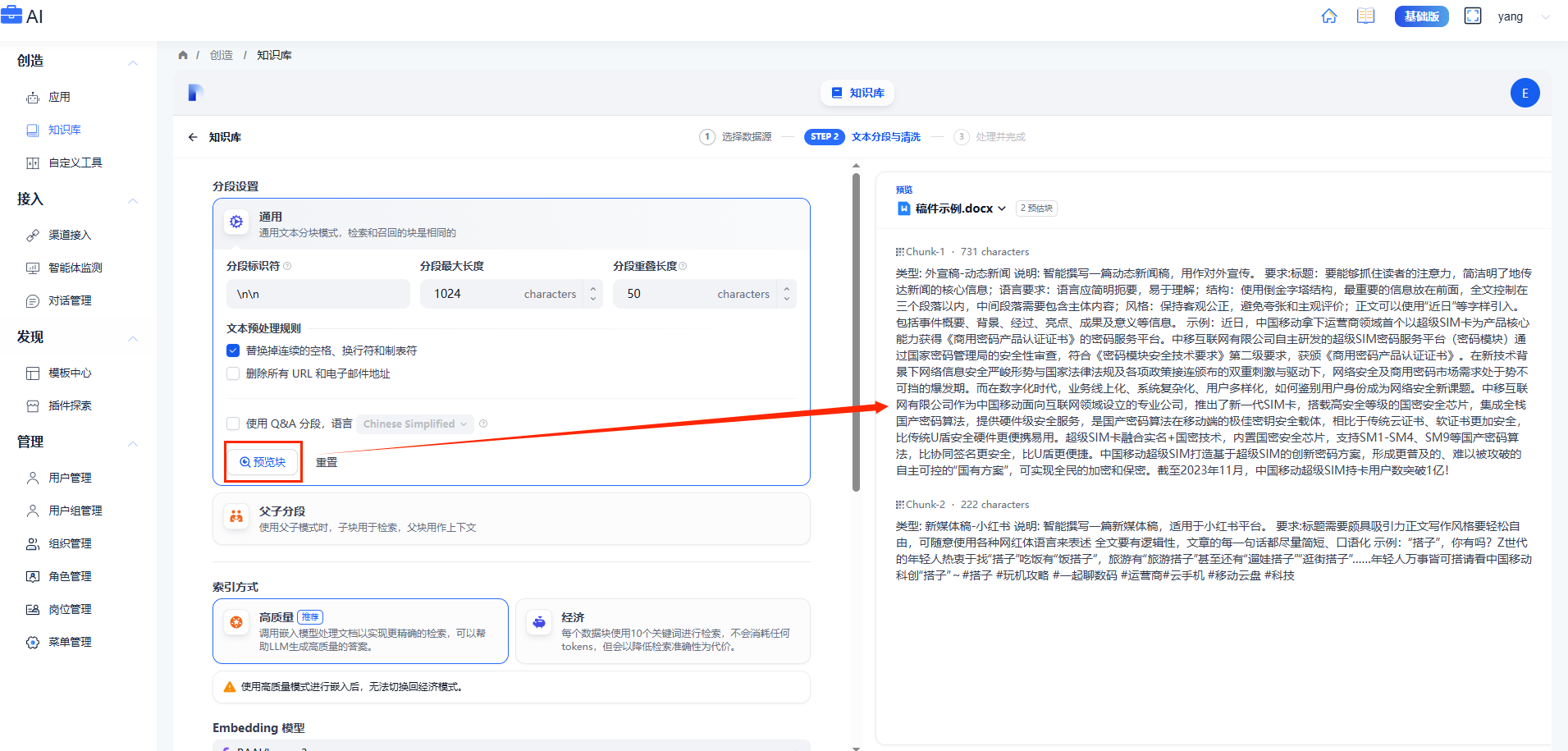

分段设置

通用模式

系统按照用户自定义的规则将内容拆分为独立的分段。当用户输入问题后,系统自动分析问题中的关键词,并计算关键词与知识库中各内容分段的相关度。根据相关度排序,选取最相关的内容分段并发送给 LLM,辅助其处理与更有效地回答。

- 分段标识符:默认值为 \n,系统将在文本中出现指定的标识符的分段,文本换行时将自动分段;

- 分段最大长度:根据分段的文本字符数最大上限来进行分段,超出该长度时将强制分段。一个分段的最大长度为 4000 Tokens;

- 分段重叠长度:分段重叠指的是在对数据进行分段时,段与段之间存在一定的重叠部分。这种重叠可以帮助提高信息的保留和分析的准确性,提升召回效果。建议设置为分段长度 Tokens 数的 10-25%。

- 文本预处理规则:文本预处理规则可以帮助过滤知识库内部分无意义的内容。例如替换连续的空格、换行符和制表符;删除所有 URL 和电子邮件地址。

配置完成后,点击”预览块”即可查看分段后的效果。你可以直观的看到每个区块的字符数。如果重新修改了分段规则,需要重新点击按钮以查看新的内容分段。

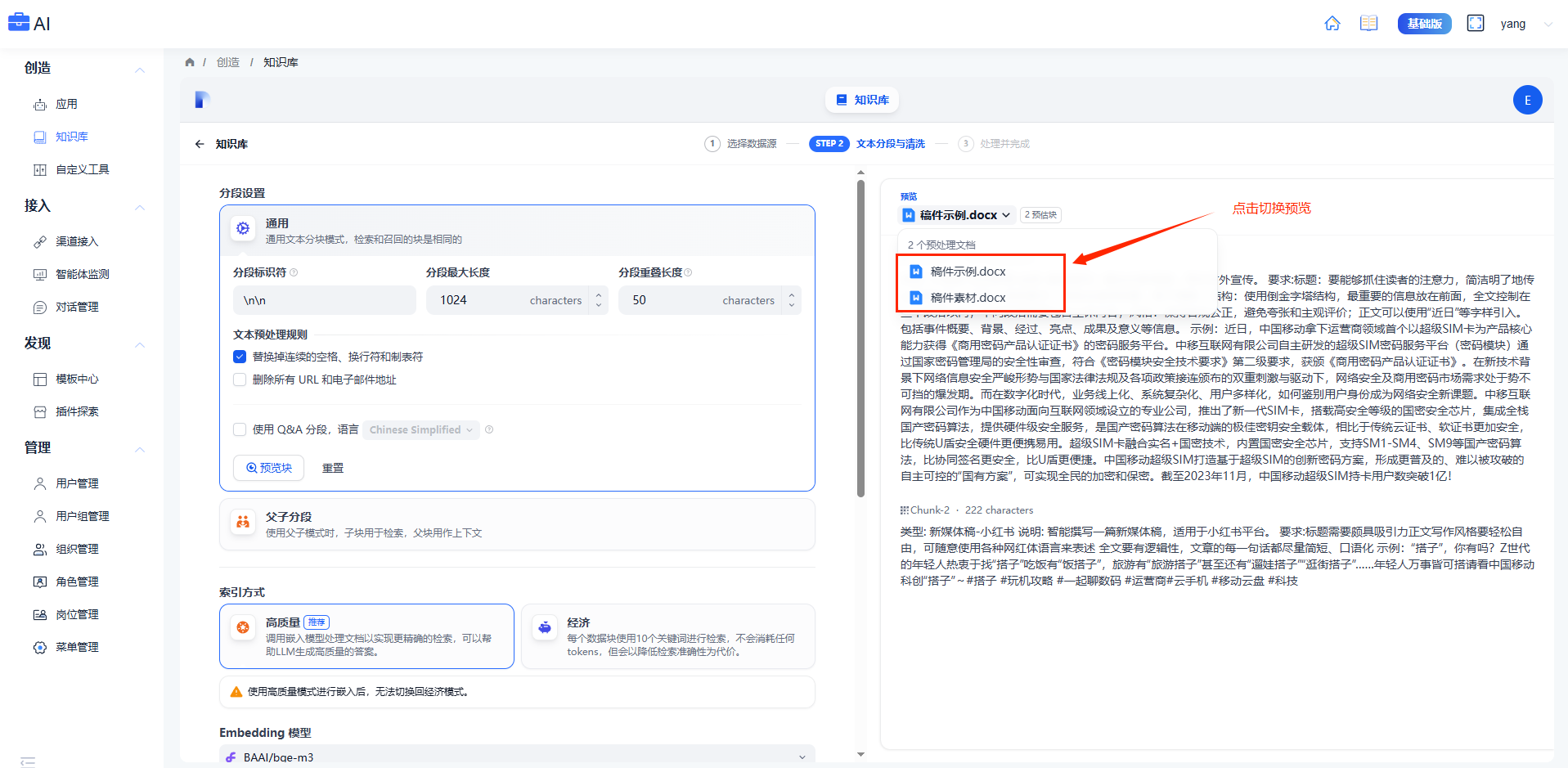

若同时批量上传了多个文档,轻点顶部的文档标题,快速切换并查看其它文档的分段效果。

父子分段

父子模式采用双层分段结构来平衡检索的精确度和上下文信息,让精准匹配与全面的上下文信息二者兼得。

其中,父区块保持较大的文本单位(如段落),提供丰富的上下文信息;子区块则是较小的文本单位(如句子),用于精确检索。系统首先通过子区块进行精确检索以确保相关性,然后获取对应的父区块来补充上下文信息,从而在生成响应时既保证准确性又能提供完整的背景信息。用户可以通过设置分隔符和最大长度来自定义父子区块的分段方式。

例如在 AI 智能客服场景下,用户输入的问题将定位至解决方案文档内某个具体的句子,随后将该句子所在的段落或章节,联同发送至 LLM,补全该问题的完整背景信息,给出更加精准的回答。

- 父块用作上下文:

- 段落:根据预设的分隔符规则和最大块长度将文本拆分为段落。每个段落视为父分段,适用于文本量较大,内容清晰且段落相对独立的文档。

- 全文:不进行段落分段,而是直接将全文视为单一父分段。出于性能原因,仅保留文本内的前 10000 Tokens 字符,适用于文本量较小,但段落间互有关联,需要完整检索全文的场景。

- 子块用于检索:

子分段文本是在父文本分段基础上,由分隔符规则切分而成,用于查找和匹配与问题关键词最相关和直接的信息。如果使用默认的子分段规则,通常呈现以下分段效果:

- 当父分段为段落时,子分段对应各个段落中的单个句子。

- 父分段为全文时,子分段对应全文中各个单独的句子。

注意,通用和父子分段的主要区别在于内容区块的分段形式。通用模式的分段结果为多个独立的内容分段,而父子模式采用双层结构进行内容分段,即单个父分段的内容(文档全文或段落)内包含多个子分段内容(句子)。

不同的分段方式将影响 LLM 对于知识库内容的检索效果。在相同文档中,采用父子检索所提供的上下文信息会更全面,且在精准度方面也能保持较高水平,大大优于传统的单层通用检索方式。

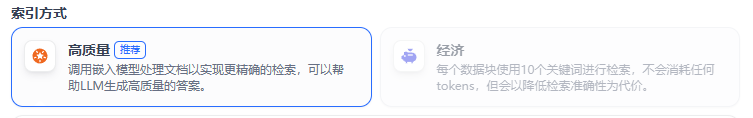

索引方式

- 高质量:调用嵌入模型处理文档以实现更精确的检索,可以帮助LLM生成高质量的答案。

- 经济:每个数据块使用10个关键词进行检索,不会消耗任何tokens,但会以降低检索准确性为代价。

注意:使用高质量模式进行嵌入后,无法切换回经济模式。

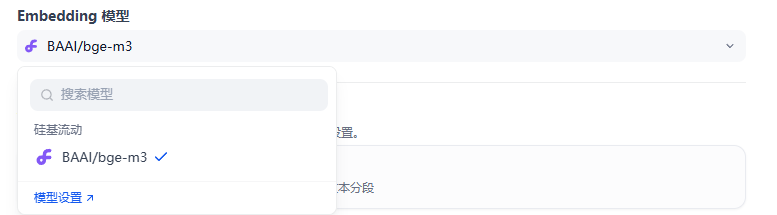

Embedding模型

- Embedding 模型用于将自然语言处理转为向量,用于后续检索和大模型处理;

- 可选择的内置embedding模型,或在模型设置中添加第三方embedding模型;

知识检索设置

- 向量检索:通过向量化用户输入的问题并生成查询向量,比较查询向量与知识库内对应的文本向量距离,寻找最近的分段内容。通过生成查询嵌入并查询与其向量表示最相似的文本分段。支持设置以下参数:

- 全文检索:索引文档中的所有词汇,从而允许用户查询任意词汇,并返回包含这些词汇的文本片段

- 混合检索:同时执行全文检索和向量检索,并应用重排序步骤,从两类查询结果中选择匹配用户问题的最佳结果,用户可以选择设置权重或配置重新排序模型。

- TopK: 用于筛选与用户问题相似度最高的文本片段。系统默认值为 3,数值越高,预期被召回的文本分段数量越多 。可选择范围是1-10。

- Score 阈值: 用于设置文本片段筛选的相似度阈值。系统默认关闭该设置,即不会对召回的文本片段相似值过滤。打开后默认值为 0.5 。可选择范围是0-1。数值越高说明对于文本与问题要求的相似度越高,预期被召回的文本数量也越少。

- Rerank模型:开启“Rerank 模型”后,系统会在语义检索后对已召回的文档结果再一次进行语义重排序,优化排序结果。设置 Rerank 模型后,TopK 和 Score 阈值设置仅在 Rerank 步骤生效。